Outils pour utilisateurs

Outils du site

Panneau latéral

site:enseignement:master:bdle:tmes:databricks

Table des matières

Utilisation de Spark sous Databricks

Il est possible d'utiliser un notebook Spark sur le cloud en utilisant le service community to databricks. Pour ce faire, commencer par créer un compte gratuit sur Databricks Community

L'environnement Databricks vous fournit un espace pour sauvegarder vos notebooks. Il fournit aussi un espace (dbfs) pour stocker les datasets que vous manipulez en TME.

Espace de travail

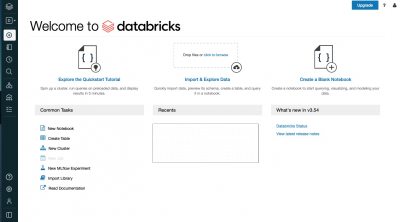

Apres création du compte, se connecter sur Databricks Community Edition. La fenetre principale est indiquée ci-dessous

La barre latérale propose plusieurs fonctionnalités:

- “Workspace” permet de gérer les notebook et d'autres fichiers de configuration

- “Data” permet d'importer des données

- “Compute” permet créer, démarrer ou arrêter un cluster

- “Jobs”, réservé à la version payante, permet de visualiser des métriques sur l'exécution des programmes.

Configuration

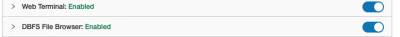

Pour avoir la possibilité d'utiliser la ligne de commande et organiser vos fichier depuis l'interface graphique, il faudra activer deux paramètres en vous navigant depuis l'interface principale

Settings → Admin console

Puis cliquer sur l'onglet Workspace Settings

Enfin, basculer Web Terminal et DBFS File Browser vers Enabled, comme indiqué dans la capture ci-dessous

Création Cluster

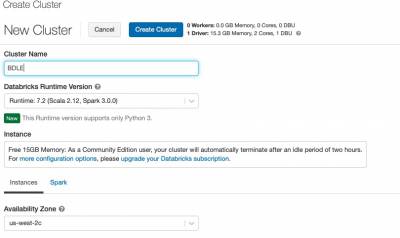

Pour la premiere utilisation, créer un cluster avec un nom au choix en gardant les paramètres par défaut

Après quelques secondes (ou minutes…), le cluster est prêt à l'usage. Il sera tué au bout de 2 heures d'inaction. s'agit d'une machine avec 15 GO de RAM, 2 coeurs et 1 Database Unit. Toutefois, la suppression du cluster ne supprime ni vos données ni vos notebook qui sont conservés dans votre espace databricks.

Chargement données

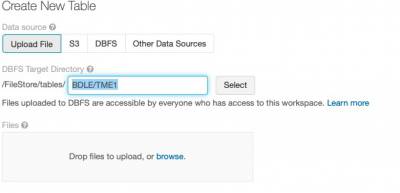

Se rendre sur l'onglet “Data”, puis cliquer sur “Add Data” du menu latéral qui apparait.

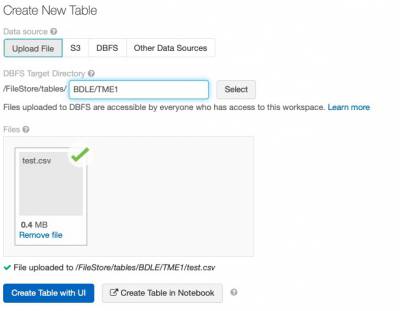

Commencer par créer un répertoire pour organiser vos données en tapant le chemin relatif dans la zone de texte

Par exemple, rajouter BDLE/TME1 pour mettre les données relative au TME1.

Charger les données en glissant déposant dans la zone. Une fois réalisé, le chemin complet va s'afficher. Vous pouvez retirer le fichier en cliquant remove, sinon il sera stocké dans le DBFS.

Le chemin vers votre fichier est celui qui devra être renseigné sur vos notebook

Il est possible de naviguer dans le Système de fichier en cliquant sur l'onglet DBFS. Ca veut permet de voir les données importées et récupérer le chemin vers celles-ci.

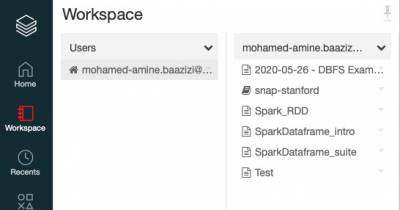

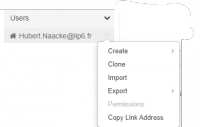

Création notebook

Cliquer sur l'onglet “Workspace” pour révéler le menu latéral. Cliquer sur la flèche sous votre nom d'utilisateur pour dérouler le menu qui permet de créer, importer ou cloner un notebook, entre autres.

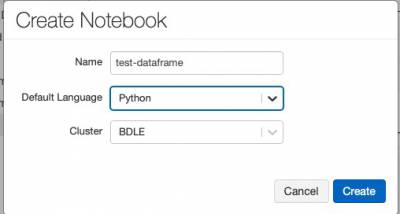

Remplir le formulaire en saisissant le nom du notebook et en choisissant le langage de programmation. Par défaut, Python est sélectionné. Il est aussi possible de choisir Scala ou R.

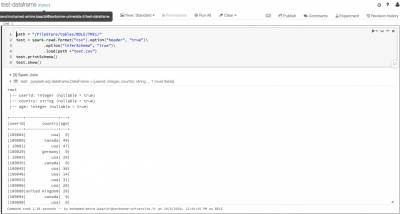

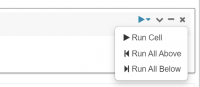

Saisir les instructions dans les cellules et executer.

Par exemple, pour charger et visualiser le contenu *test.csv* saisir les instructions suivantes

path = "/FileStore/tables/BDLE/TME1/" test = spark.read.format("csv").option("header", "true")\ .option("inferSchema", "true")\ .load(path +"test.csv") test.printSchema() test.show()

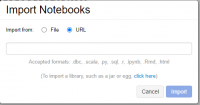

Importer un notebook

Il est aussi possible d'importer un notebook existant et d'en exporter à la fin de la séance de TME. Menu déroulant sur le nom de l'utilisateur → Import

Plan d'exécution

A faire

Divers

site/enseignement/master/bdle/tmes/databricks.txt · Dernière modification: 27/09/2021 13:02 par hubert

Outils de la page

Sauf mention contraire, le contenu de ce wiki est placé sous les termes de la licence suivante : CC Attribution-Noncommercial-Share Alike 3.0 Unported